Цель — доступность и полезность информации

Миссия Google заключается в организации мировой информации, обеспечении её доступности и пользы для всех. Залогом успеха реализации этой миссии является непрерывное сканирование интернета в поисках свежего содержания и добавлениe его в наш индекс. Мы регулярно сканируем миллиарды страниц, а знаем о существовании ещё большего числа документов: мы индексируем веб-страницы, форумы, изображения, новости, видео, книги и многое другое. Но иногда пользователи хотят найти ещё больше. Зачастую это информация, которая опубликована онлайн, но по тем или иным причинам недоступна для наших сканеров. Если у сканеров нет доступа к документам, поисковой системе будет сложно их полностью проиндексировать и предоставить пользователя

Проиндексированы ли ваши веб-страницы?

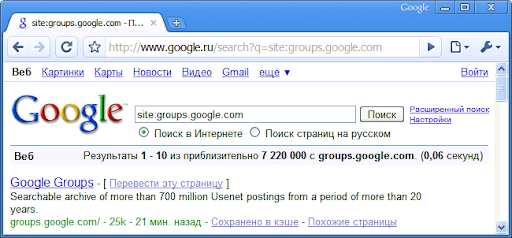

Проверить, насколько проиндексировано содержание вашего сайта, легко: для этого произведите поиск URL-адреса вашего домена с оператором «site:». Например, чтобы проверить какая часть сайта с ссылками проиндексирована нашим поисковиком, нужно сделать запрос [site:http://vovka.su/gde-kupit-vechnye-ssylki/] (в тексте мы обычно заключаем поисковые запросы в квадратные скобки, но этого не делать непосредственно в строке поискового запроса; также обратите внимание, что в запросе после оператора «site:» отсутствует пробел). И, таким образом, можно узнать попали ли в индекс установленные ссылки.

В данном примере видно, что проиндексировано большое количество страниц, а первым результатом является главная страница Групп Google. Это хорошо — в наличии множество информации, многие сообщения уже проиндексированы и доступны пользователям.

Если ваш сайт плохо индексируется, то в окне результатов поиска вы либо обнаружите отсутствие ссылок на содержание вашего сайта, либо таких ссылок будет мало. Эта проблема проиллюстрирована в следующем примере. В данном случае, домен example.com не сканируется нашим поисковым роботом. Если вы сделаете запрос [site:example.com], в результатах поиска вы увидите, что, в отличие от Групп Google, страницы сайта example.com не индексируются:

Мой сайт выглядит похоже на скриншот вверху! Что делать, чтобы исправить ситуацию?

Если ваш сайт индексируется так же, как показано в предыдущем примере, или совсем не индексируется, не стоит впадать в панику. В интернете ничто не постоянно. В большинстве случаев можно выяснить и устранить эту проблему достаточно быстро. Вот несколько вещей, которые стоит проверить:

- Является ли ваш сайт новым?

- Открыт ли ваш сайт для сканирования поисковыми роботами?

Поисковые роботы зачастую следуют инструкциям, описанным в файле robots.txt каждого сайта (если такой файл создан). Этот текстовый файл обычно написан вручную и находится в корне сайта. Он сообщает поисковым системам о том, какие части вашего сайта открыты/закрыты для сканирования и индексирования. Иногда, создавая этот файл, веб-мастера случайно блокируют доступ всем поисковым роботам неправильными настройками Allow / Disallow. Это может произойти и из-за того, что файл robots.txt не редактировался и не исправлялся с начала разработки сайта.В некоторых случаях веб-мастера блокируют доступ всем поисковым роботам, чтобы избежать чрезмерной нагрузки на веб-сервер, которая может произойти при интенсивном сканировании сайта. В такой ситуации, вместо того, чтобы запрещать сканирование всего сайта, будет полезно идентифицировать отдельные страницы, которые являются причиной проблемы, и блокировать только их. Также стоит задать частоту сканирования в настройках инструментов для веб-мастеров Google, если вы считаете, что это поможет уменьшить нагрузку на сервер.

Содержимое файла robots.txt определённого сайта (также вашего) можно посмотреть в любом браузере. Например, можно посмотреть содержимое файла robots.txt сайта YouТube.com.

В консоли инструментов для веб-мастеров Google есть программа для анализа файла robots.txt. Там же можно создать файл robots.txt для вашего сайта, если у вас его нет (хотя наличие на сайте файла robots.txt необязательно).

Следующие строки в файле robots.txt запрещают доступ всем поисковым роботам ко всему содержимому сайта («/» — обозначает корневой уровень файлового дерева сайта):

User-agent: *

Disallow: /Следующие строки в robots.txt разрешают доступ к содержимому сайта всем роботам:User-agent: *

Disallow:Заметьте, что после директивы «Disallow:» ничего не написано. Отсутствие у вашего сайта файла robots.txt имеет такой же эффект.Комментарии в файлах robots.txt можно добавлять используя символ # в начале строки, например так:

# это комментарийИнформацию об ошибках сканирования (например URL, запрещенные файлом robots.txt) вы можете найти в консоли инструментов для веб-мастеров Google. Чтобы иметь доступ к этой информации, убедитесь, что ваш сайт добавлен и подтвержден.

- Не запрещает ли ваш сайт индексирование содержания?

Некоторые сайты разрешают сканирование содержания с веб-сервера, но одновременно запрещают его индексирование. Запрет индексирования обычно делается с помощью атрибута «noindex» в метатеге «robots» файлов. Вы можете проверить, есть ли такой тег на вашем сайте, если посмотрите исходный код главной страницы вашего сайта (следует помнить, что этот тег можно размещать на каждой странице индивидуально, а не только на главной).

Часто причиной этого является то, что настройка, включенная по умолчанию, не была выключена в программном обеспечении сайта. Иногда названия таких настроек могут быть неясны или слабо связаны с этим метатегом. Например, название настройки может быть «видимость сайта» или «разрешить поисковым роботам искать на вашем сайте».

- Вы уверены, что нет других технических проблем, блокирующих поисковые системы?

Иногда есть технические проблемы, которые мешают нам сканировать ваш сайт. Если вы подозреваете, что именно такие проблемы являются причиной, возможно, вам стоит задать вопрос на нашем справочном форуме для веб-мастеров или попросить помощи у вашего хостинг-провайдера.

- Соответствует ли ваш сайт рекомендациям по обеспечению качества Google?

Мы можем удалить сайт из результатов поиска, если он не соответствует рекомендациям качества. Если вы считаете, что ваш сайт, возможно, нарушает эти рекомендации, приведите его в соответствие с требованиями, а затем отправьте запрос на пересмотр сайта со своего аккаунта в консоли инструментов для веб-мастеров. Если смысл некоторых наших рекомендаций не совсем понятен, стоит обратиться к веб-мастерам или сотрудникам Google в справочном форуме для веб-мастеров.Если вы проверили свой сайт при помощи вышеупомянутым методов, и вам кажется, что ваш сайт уже давно должен был быть отсканирован и проиндексирован, возможно, вам будет полезно посмотреть в архивe форума, не сталкивались ли с похожей проблемой другие веб-мастера. Вы также можете задать свой вопрос на форуме. После того как вы приняли необходимые меры, сканирование и индексирование вашего сайта в большинстве случаев — это вопрос времени.

Спасибо, что у вас нашлось время и терпение, чтобы проверить свой сайт. Мы надеемся, это поможет сделать ваш сайт эффективным для поискового сканирования и улучшить его видимость для ваших пользователей!

Любопытно. Хотелось бы еще чего-нибудь интересного об этом же.